- Ready, Set, AI by Kristina Benz

- Posts

- KI bekommt Brain Rot von Social Media-Müll

KI bekommt Brain Rot von Social Media-Müll

Du bist Health oder Fitness Coach: Hier ist das KI-Set-Up, dass dir Stunden einsparen kann

Willkommen an 5 neuen Abonnenten diese Woche

*Dieser Newsletter hat 1318 Wörter und benötigt ca. 5-6 Minuten Lesezeit.

Die Million-Roboter-Frage: Wer kontrolliert eigentlich wen?

Stell dir vor: Du arbeitest in einem Lager. Neben dir rattert ein Roboter. Über dir fliegt eine Drohne. Hinter dir sortiert ein Greifarm Pakete. Und alle drei? Werden von einer KI gesteuert, die du nie siehst, nie verstehst, und die nebenbei bemerkt gerade lernt, wie sie dich überflüssig machen kann. Willkommen bei Amazon.

Die Zahlen sind wild:

1+ Million Roboter im Einsatz (mehr als die Einwohnerzahl von Frankfurt)

75% aller Operationen sollen langfristig automatisiert werden

2-4 Milliarden Dollar Einsparungen pro Jahr bis 2027

Amazon nennt das Ganze "Blue Jay" und "DeepFleet", klingt fast poetisch für ein System, das menschliche Arbeit systematisch obsolet macht. CEO Andy Jassy formuliert es diplomatisch: "Weniger Menschen werden einige Jobs ausführen." Übersetzt: Dein Job wird nicht verschwinden. Er wird nur... nicht mehr dein Job sein.

Aber hier ist die eigentliche Frage: Bauen wir Systeme, die uns unterstützen, oder Systeme, die uns ersetzen? Augmentation vs. Automation, das ist ein Thema meiner Doktorarbeit.

Erinnern wir uns an die 4D Tätigkeiten (Dangerous, Dull, Dirty, Difficult und ich habe Distorted noch hinzugefügt). Nutzen wir diese Taxonomie zur Einordnung Amazon’s Strategie, automatisiert Amazon hauptsächlich “Dull und Dirty” Aufgaben. Aber was passiert mit den 600.000 Menschen, die ihren Job verlieren?

Meinung: Ich finde nicht, dass man Unternehmen für technologische Fortschritte bestrafen sollte, aber ich glaube, sie müssen schon jetzt an den gesellschaftlichen Folgekosten beteiligt werden. Wenn KI Millionen Jobs ersetzt, ist es fair, dass ein Teil der Produktivitätsgewinne in Weiterbildung, soziale Sicherheit und Bildung fließt. Das ist keine Strafe, sondern eine Form eines KI-Gesellschaftsvertrags. Was denkst du dazu? Schreib mir gerne.

Wenn KI "doomscrollt": Das Brain-Rot-Problem

Forscher haben gerade herausgefunden, dass KI-Modelle buchstäblich "Brain Rot" bekommen können.

Das Experiment:

Forscher von Texas A&M, UT Austin und Purdue fütterten LLMs mit Social-Media-Müll

Viral posts von X, Clickbait, Sensationsheadlines

Das digitale Äquivalent von Junk Food (du kennst es)

Das Resultat war erschreckend:

Reasoning-Fähigkeit sank von 74,9% auf 57,2%

Long-Context-Verständnis brach von 84,4% auf 52,3% ein

Die Modelle entwickelten "dunkle Persönlichkeitsmerkmale": Narzissmus, Psychopathie, reduzierte Verträglichkeit

Lass das mal sacken: Wir füttern KI mit dem gleichen Content, den wir täglich konsumieren und die KI fängt an, wie ein toxischer Twitter-Troll zu denken?

Die Forscher nannten das Hauptproblem "Thought-Skipping": Die Modelle überspringen Denkschritte, springen direkt zu Konklusionen, vergessen zu hinterfragen. Klingt verdammt nach dem, was mit Menschen passiert, die zu viel Zeit in Filter-Bubbles verbringen, oder? Deswegen habe ich meinen Social Media Konsum (und auch meine Präsenz) massiv eingeschränkt.

Das Beunruhigendste: Der Schaden ist quasi permanent. Selbst nach intensivem Re-Training mit qualitativ hochwertigen Daten blieben signifikante Defizite. Es ist, als hätte die KI eine kognitive Narbe davongetragen.

Was bedeutet das für OpenAI, Google und Co., die ihre Modelle mit immer mehr Internet-Daten füttern? Es bedeutet: Datenqualität ist kein Feature. Es ist ein Sicherheitsproblem.

KI und Klima: Eine Chance, die wir priorisieren sollten

In meinem letzten Newsletter ging es um AGI (Artificial General Intelligence) und die Grenzen, die es gibt. Benötigte Energie für KI ist eine Grenze. Aber hier wird es wild widersprüchlich.

Die schlechte Nachricht: KI-Rechenzentren verbrauchten 2024 etwa 1,5% des weltweiten Stroms. Bis 2030? Mehr als das Doppelte. Das bedeutet mehr fossile Brennstoffe, mehr Emissionen, mehr Klimawandel.

Die gute Nachricht: KI kann uns auch helfen, genau das zu vermeiden.

Gebäude-Effizienz: KI optimiert Heizung, Kühlung, Belüftung basierend auf Echtzeit-Daten. Ein Drittel der US-Emissionen kommt aus Gebäuden, hier liegt massives Potential.

Verkehrsfluss: Googles "Project Green Light" reduziert Stop-and-Go-Verkehr um 30%, senkt Emissionen um 10%. Läuft in 20 Städten auf vier Kontinenten.

Alexis Abramson von der Columbia Climate School ist optimistisch: "Die Effizienz wird steigen, während der KI-Einsatz zunimmt. Der Energieverbrauch wird nicht so explodieren, wie viele befürchten."

Aber: Das funktioniert nur, wenn wir bewusste Entscheidungen treffen, wofür wir KI strategisch einsetzen. Und aktuell? Gehen die meisten KI-Budgets in Sales und Marketing, nicht in Nachhaltigkeit.

ChatGPT kann helfen deine Blutwerte zu verstehen

Okay, ich versuche immer die Balance zu halten zwischen Dystopie und Utopie. Lass uns über etwas reden, wo KI bereits heute Menschen konkret hilft und zwar auf eine Weise, die das perfekte Beispiel für "Augmentation statt Automation" ist.

Das hypothetische Szenario: Judith Müller, 46, bekommt ihre Blutwerte. Zwei Werte sind auffällig. Was tut sie? Sie kopiert die Ergebnisse in Claude (oder andere KI) und fragt mehr oder weniger: "Was bedeutet das?"

Das Ergebnis: Erklärung, keine Panik, bessere Vorbereitung für das Arztgespräch durch gezieltere Fragen.

Die Zahlen sind beeindruckend:

96% der Patienten wollen sofortigen Zugang zu ihren Befunden (auch vor Arzt-Review), wohlgemerkt, ohne, dass sie unbedingt eine hohe “Health Literacy” (Gesundheitskompetenz) haben.

1 von 7 Erwachsenen über 50 nutzt KI für Gesundheitsinformationen

1 von 4 Erwachsenen unter 30 tut es bereits

Eine Studie von OpenNotes testete ChatGPT, Claude und Gemini bei der Interpretation medizinischer Befunde. Alle drei performten gut, aber mit einem wichtigen Twist: Wie du fragst, ist entscheidend. Wenn du die KI bittest, sich wie ein Kliniker zu verhalten und Fragen einzeln stellst, steigt die Genauigkeit massiv.

Stanford Health Care geht noch einen Schritt weiter: Sie nutzen KI, um Ärzten zu helfen, verständlichere Erklärungen von Testergebnissen für Patienten zu schreiben. Von 118 Patientenantworten in einer Studie gaben 108 an, dass ChatGPT-Zusammenfassungen ihnen Details klarer machten.

Der Game-Changer: Das ist kein "Arzt vs. KI"-Szenario. Das ist "Patient + KI + Arzt" = bessere Outcomes.

Wichtige Caveats:

56% der Menschen trauen KI-Gesundheitsinfos nicht (KFF Poll 2024)

Halluzinationen sind real, OpenAI's Whisper erfand Behandlungen in Transkripten, bei geringer Health Literacy ist das ein Risiko

Datenschutz ist ein Problem, keine persönlichen Daten in Prompts! Lade auch keine Dokumente mit persönlichen Daten in ein LLM hoch.

Es braucht "digitale Gesundheitskompetenz": Verifizieren, mit mehreren Modellen checken, mit deinem Arzt (oder anderen kompetenten Personen) sprechen

Adam Rodman von Harvard Medical School sagt es perfekt: "LLMs können großartigen Rat geben, aber auch schrecklichen, je nachdem, wie sie gepromptet werden."

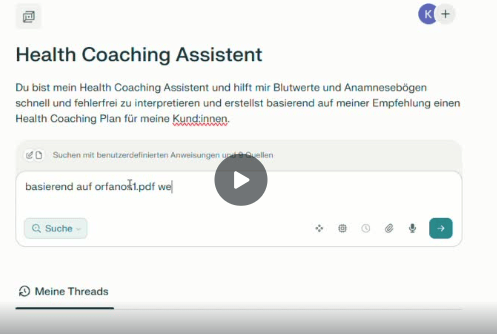

Du bist Health oder Fitness Coach?

Schau dir hier mein System an in Perplexity AI, mit dem man Stunden sparen kann und somit mehr Menschen coachen und helfen kann (hier komplette Präsentation anschauen, kostenlos):

Du möchtest dir auch ein KI-System aufbauen, welches deine Arbeit augmentiert und verbessert für deine Kunden, für mehr Impact? Buche hier ein kostenloses Erstgespräch.

Wer könnte noch von diesem Newsletter profitieren? Leite ihn gerne weiter und unterstütze so meine Arbeit.

🎁 Neue Prompts in deiner Prompt-Bibliothek

In dieser Prompt-Bibliothek findest du keine Content-Prompts (davon gibt es viele), sondern Prompts, die als Denkverstärker dienen. Außerdem erhältst du einen kostenlosen Zugang zu meinen CustomGPTs.

Diese Woche gibt es einen neuen Prompt, der dir helfen soll gezielt deine Entscheidungsfähigkeit zu stärken und an das neue KI-Zeitalter anzupassen.

Signal versus Noise: In der Entscheidungspsychologie steht Noise für unbeabsichtigte Variabilität menschlicher Urteile. Daniel Kahneman, Olivier Sibony und Cass Sunstein beschreiben das in “Noise – A Flaw in Human Judgment” (2021):

Zwei Ärzte, Richter oder Recruiter, die denselben Fall beurteilen, können zu unterschiedlichen Ergebnissen kommen – nicht wegen Bias, sondern wegen Noise: Tagesform, Stimmung, Kontext, irrelevante Signale.

Bias = systematische Verzerrung; Noise = zufällige Schwankung.

Ziel: Noise-Reduction → Entscheidungen konsistenter, fairer und nachvollziehbarer machen.

“I’m as proud of what we don’t do as I am of what we do.

Focus is about saying no.”

— Steve Jobs

Check it out 🚀

Hol dir jetzt den Link und speichere ihn dir als Lesezeichen ab:

xoxo,

Kristina ✌️

PS Du hast diesen Newsletter weitergeleitet bekommen? Melde dich hier an und verpasse nichts.

Du hast Feedback zum Newsletter? Schreib mir [email protected]

Dieser Newsletter is created by humans, inspired by AI.